负载均衡的工作原理是通过分散网络负载,提高系统的整体性能和可靠性。它根据当前的网络流量、服务器性能等条件,智能地将请求分配给最合适的服务器处理。负载均衡采用多种技术,如DNS负载均衡、特定服务软件的负载均衡策略以及硬件负载均衡等。其核心在于智能分配和调度,确保系统资源得到高效利用,提高访问速度,增强系统的可扩展性和稳定性。

本文目录导读:

随着互联网技术的飞速发展,网络应用面临着巨大的流量压力,为了应对这种压力,负载均衡技术应运而生,负载均衡能够优化网络资源分配,提高系统的稳定性和性能,本文将详细介绍负载均衡的工作原理及其核心机制。

负载均衡概述

负载均衡是一种网络架构技术,旨在优化网络资源的分配和使用,在负载均衡系统中,通过网络流量的分发,使得多台服务器能够共同分担负载,从而提高系统的整体性能和可靠性,负载均衡技术广泛应用于各种网络应用场景,如云计算、数据中心、Web服务器集群等。

负载均衡的工作原理

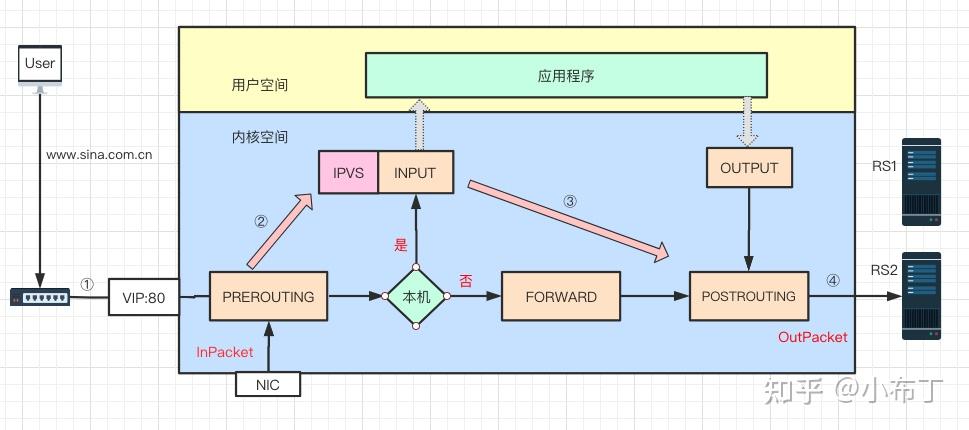

负载均衡的工作原理主要包括以下几个步骤:

1、流量检测:负载均衡器会实时监测网络流量,包括请求的数量、服务器的负载情况等,这是实现负载均衡的基础。

2、决策算法:根据收集到的流量信息,负载均衡器会采用特定的算法进行决策,确定哪些请求应该发送到哪些服务器,常见的负载均衡算法包括轮询法、加权轮询法、最少连接法等。

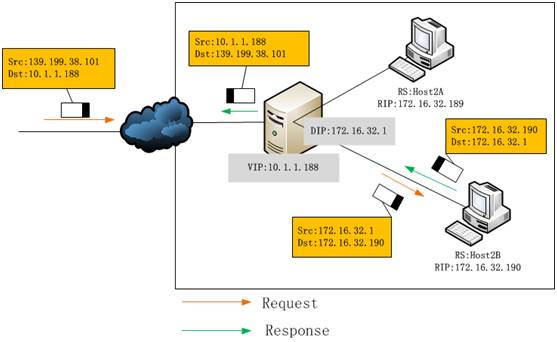

3、请求分发:根据决策结果,负载均衡器将请求分发给相应的服务器,这个过程需要保证请求的转发速度和准确性。

4、实时监控与调整:负载均衡器会实时监控服务器的负载情况,并根据实际情况调整负载均衡策略,以保证系统的性能。

负载均衡的核心机制

负载均衡的核心机制主要包括以下几个方面:

1、DNS负载均衡:通过DNS实现域名解析的负载均衡,当访问特定域名时,DNS服务器会根据配置的权重将请求分发到不同的服务器。

2、HTTP重定向负载均衡:在Web服务器集群中,通过HTTP重定向实现负载均衡,当用户访问某个特定的URL时,服务器会根据配置将请求重定向到其他服务器。

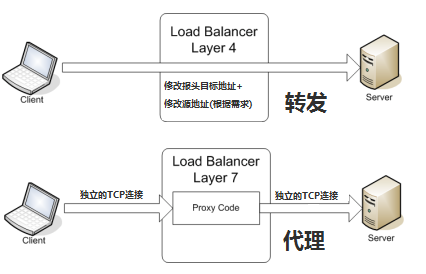

3、反向代理负载均衡:通过反向代理服务器实现负载均衡,客户端的请求首先发送到反向代理服务器,然后由代理服务器根据配置将请求转发给后端服务器,这种方式可以有效隐藏后端服务器的细节,提高系统的安全性。

4、链路层负载均衡:在网络的物理层实现负载均衡,通过特殊设备监控网络流量,并根据配置将流量分发到不同的链路或服务器,这种方式适用于大型网络场景,如数据中心。

负载均衡的优势与挑战

负载均衡的优势主要包括:

1、提高系统的性能和可靠性:通过分担负载,提高系统的整体处理能力和稳定性。

2、优化资源分配:根据服务器的负载情况动态分配请求,实现资源的合理利用。

3、扩展性强:可以方便地扩展系统规模,应对大规模流量压力。

负载均衡也面临一些挑战:

1、复杂性:需要配置和管理复杂的网络架构,包括服务器集群、负载均衡器等。

2、性能瓶颈:随着请求量的增加,负载均衡器可能成为系统的性能瓶颈。

3、实时性要求:需要实时收集和分析流量信息,以便做出准确的决策。

负载均衡是一种重要的网络技术,能够优化网络资源的分配和使用,提高系统的性能和可靠性,通过流量检测、决策算法和请求分发等步骤,负载均衡实现了在网络层面上的负载分担,DNS负载均衡、HTTP重定向负载均衡、反向代理负载均衡和链路层负载均衡等核心机制为负载均衡提供了多种实现方式,负载均衡也面临一些挑战,如复杂性、性能瓶颈和实时性要求等,随着技术的不断发展,我们需要不断探索和改进负载均衡技术,以应对未来的网络挑战。

京公网安备11000000000001号

京公网安备11000000000001号 京ICP备11000001号

京ICP备11000001号

还没有评论,来说两句吧...